KI-Systeme sind massive Stromfresser – Saarbrücker Forscher machen sie 90 Prozent effizienter

KI verbraucht enorme Mengen Strom. Deutsche Forscher haben eine Methode entwickelt, die KI-Modelle um 90 Prozent energieeffizienter macht.

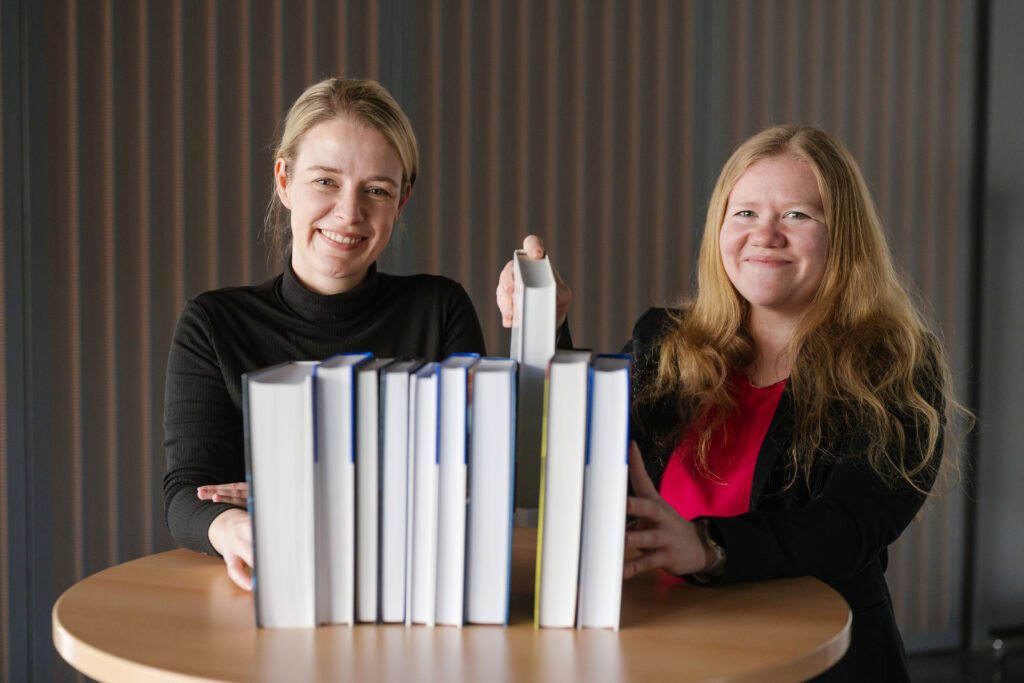

Man muss nicht die ganze Bibliothek durchforsten, wenn nur wenige Bücher die passende Antwort liefern. Nach diesem Prinzip entwickeln die Forscherinnen Sabine Janzen (links) und Hannah Stein (rechts) eine Methode, um Künstliche Intelligenz deutlich energieeffizienter zu gestalten. © Oliver Dietze

Künstliche Intelligenz ist ein Energiefresser – so massiv, dass Konzerne wie Microsoft alte Atomkraftwerke reaktivieren, um ihre Rechenzentren zu betreiben. Three Mile Island, bekannt durch den schwersten Nuklearunfall der USA, könnte bald wieder Strom für KI liefern. Auch Amazon und Google stecken Milliarden in Atomkraft, um den gewaltigen Stromhunger ihrer KI-Systeme zu stillen. Doch muss Künstliche Intelligenz wirklich so viel Energie verschlingen? Ein Forschungsteam der Universität des Saarlandes und des Deutschen Forschungszentrums für Künstliche Intelligenz (DFKI) zeigt, dass es auch anders geht. Ihre Technologien könnten KI-Modelle um bis zu 90 Prozent energieeffizienter machen – ohne Leistungseinbußen.

KI soll energieeffizienter werden: Die unsichtbare Last der Digitalisierung

Viele denken bei Energieverbrauch an Industrieanlagen oder den Verkehr. Doch auch unsere digitale Welt hat eine massive Energiebilanz. Der Strombedarf von Rechenzentren in Deutschland hat sich in den letzten zehn Jahren mehr als verdoppelt. Besonders rechenintensive KI-Modelle treiben den Verbrauch in die Höhe. Ob es um die Erstellung von Bildern, das Analysieren von Texten oder das Training neuer Modelle geht – alles kostet Strom. Global summiert sich der KI-Bedarf auf mehrere Terawattstunden.

„Künstliche Intelligenz kann erheblich energieeffizienter werden. Mit den richtigen Methoden können wir die Rechenzentren der Zukunft nachhaltiger gestalten“, sagt Professor Wolfgang Maaß, Leiter des Forschungsteams an der Universität des Saarlandes und am DFKI.

Intelligente Kompression: Schlankere Modelle, weniger Verbrauch

Das Saarbrücker Forschungsteam setzt auf Wissensdestillation – eine Technik, bei der große KI-Modelle auf ihre essenziellen Bestandteile reduziert werden. Das Ergebnis: schlankere, spezialisierte Schülermodelle, die mit bis zu 90 Prozent weniger Energie auskommen, aber trotzdem leistungsfähig bleiben.

„Indem wir die Modelle kleiner und effizienter machen, tragen wir zum einen zu mehr Nachhaltigkeit bei“, erklärt Dr. Sabine Janzen vom DFKI. „Zum anderen ermöglicht es kleineren Unternehmen, leistungsfähige KI-Modelle zu nutzen, ohne riesige Rechenzentren betreiben zu müssen.“

Automatische Optimierung: Wie KI sich selbst effizienter macht

Neben der Wissensdestillation nutzen die Forscher die sogenannte Neuronale Architektursuche. Normalerweise müssen Experten neuronale Netze manuell entwerfen, anpassen und optimieren. Das kostet Zeit und Energie. Hier übernimmt die KI selbst: Sie testet und findet automatisch die beste Architektur für ein Modell – mit maximaler Effizienz und minimalem Stromverbrauch.

„Anstatt die Zusammensetzung der neuronalen Netze manuell zu entwerfen, verwenden wir dieses Verfahren, bei dem KI automatisch die beste Architektur findet“, erklärt Dr. Sabine Janzen. Weniger Verbrauch, geringere Kosten, weniger Aufwand – ein echter Gewinn für Unternehmen und Umwelt.

KI für Recycling: Mit weniger Energie mehr erreichen

Wie lassen sich diese Methoden in der Praxis nutzen? Ein Beispiel liefert die Zusammenarbeit mit der Stahl Holding Saar. Dort soll eine KI helfen, Stahlschrott effizienter zu sortieren. Das Problem: Das bisherige Modell war riesig und verbrauchte viel Energie. Die Forscher komprimierten es – nun ist es nicht nur sparsamer, sondern sogar leistungsfähiger.

„Wir komprimieren das visuelle Modell zur Schrottsortierung. Dadurch wird es kompakt, arbeitet energieeffizient und zum Teil sogar performanter“, sagt Sabine Janzen. So werden nachhaltige Technologien nicht nur ein Umweltfaktor, sondern auch ein echter Wettbewerbsvorteil.

Besser planen: KI-Verbrauch berechnen, bevor die Rechnung kommt

Für Unternehmen ist eine große Herausforderung, dass der Energieverbrauch von KI oft schwer kalkulierbar ist. Das Saarbrücker Forschungsteam entwickelt deshalb ein Prognosetool.

„Bislang können Entscheidungsträger nur schwer abschätzen, für welche Modelle sie wie viel Energie verbrauchen werden“, erklärt Hannah Stein, Doktorandin am DFKI. „Wir erarbeiten daher ein Werkzeug, das zuverlässige Prognosen ermöglicht, wie der genaue Energieverbrauch und die zusammenhängenden Kosten der KI-Modelle aussehen werden.“ Wer weiß, was KI verbraucht, kann Rechenlasten besser verteilen, Kosten sparen und nachhaltiger wirtschaften.

Diese Technologien sind nicht nur Theorie – sie sollen bald breite Anwendung finden. Vom 31. März bis 4. April präsentieren die Forscher ihre Ergebnisse auf der Hannover Messe am Stand des Bundesministeriums für Wirtschaft und Klimaschutz.

Kurz zusammengefasst:

- KI-Systeme verbrauchen enorme Mengen Strom, weshalb große Tech-Konzerne sogar in Atomkraft investieren, um ihre Rechenzentren zu betreiben.

- Forscher aus Saarbrücken haben eine Methode entwickelt, mit der KI-Modelle durch Wissensdestillation und neuronale Architektursuche bis zu 90 Prozent energieeffizienter werden.

- Diese Technologien könnten Rechenzentren nachhaltiger machen und zugleich kleineren Unternehmen den Zugang zu leistungsfähiger KI erleichtern.

Bild: © Oliver Dietze

2 -Gedanken zu “KI-Systeme sind massive Stromfresser – Saarbrücker Forscher machen sie 90 Prozent effizienter”