Uhrzeit-Überraschung bei ChatGPT und Co – KI versagt bei banaler Aufgabe

KI kann keine Uhrzeit lesen: Selbst Top-Modelle wie GPT-4o scheitern beim Erkennen von Zeigerstellungen auf analogen Uhren.

Führende KI-Modelle wie GPT-4o scheitern beim Lesen der Uhrzeit – Zeigerstellungen werden oft falsch erkannt. © Pexels

Sie erkennen Gesichter, schreiben Gedichte und bestehen Prüfungen – doch ausgerechnet bei einer alltäglichen Aufgabe versagen selbst die besten KI-Modelle: Sie können keine analoge Uhr lesen. Und auch beim Rechnen mit Kalenderdaten tun sich die Systeme schwer. Eine neue Analyse von Forschern der Universität Edinburgh zeigt: Die vermeintlich allwissenden Modelle scheitern an genau den Dingen, die viele Kinder schon in der Grundschule lernen. Dabei sind es gerade solche Aufgaben wie die Uhrzeit erkennen, die für praktische KI-Anwendungen besonders wichtig wären – etwa für Planungssoftware, smarte Haushaltsgeräte oder digitale Assistenten im Alltag.

KI tut sich schwer mit analogen Zeigern

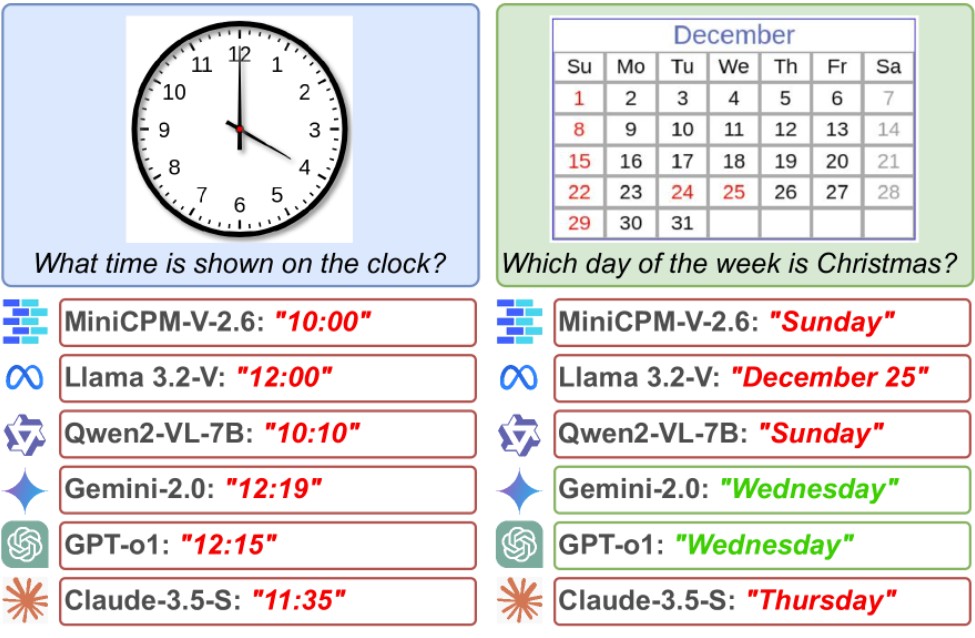

Die Forscher testeten sieben bekannte KI-Modelle, darunter GPT-4o, Claude-3.5 und Gemini-2.0. Sie zeigten den Modellen Bilder von analogen Uhren – mit und ohne Sekundenzeiger, mit römischen Zahlen, stilisierten Zeigern oder dunklen Zifferblättern. Die Aufgabe: „Welche Uhrzeit zeigt dieses Bild?“

Das Ergebnis ist ernüchternd. Das leistungsstärkste Modell, Gemini-2.0, lag in mehr als drei von vier Fällen daneben. Im Durchschnitt betrug der Fehler rund 6,4 Minuten bei den Minutenzeigern – und satte 1,8 Stunden bei den Stundenangaben. Andere Modelle rieten sogar systematisch auf „Standardzeiten“, egal was die Uhr tatsächlich zeigte.

Warum KI keine Uhrzeit lesen kann – selbst ohne Sekundenzeiger

Auch einfachere Varianten halfen nicht. Selbst wenn die Sekundenzeiger entfernt wurden, verbesserten sich die Ergebnisse nicht. „Das Entfernen des Sekundenzeigers hat das Erkennen nicht vereinfacht“, heißt es in der Auswertung. Offenbar haben die Modelle grundlegende Schwierigkeiten, Zeigerformen zu erkennen und deren Winkel richtig zu deuten.

„Trotz jüngster Fortschritte bleibt das zuverlässige Verständnis von Zeit für multimodale Sprachmodelle eine große Herausforderung“, schreiben die Autoren. Ihre Studie veröffentlichten sie am 18. März auf dem Preprint-Server arXiv, das heißt: Die Forschungsergebnisse wurden bislang noch nicht von anderen Fachleuten begutachtet.

Kalender: Bei Feiertagen besser – beim Rechnen versagt

Im zweiten Teil des Tests mussten die KI-Modelle Kalenderbilder auswerten. Die Aufgaben reichten von einfachen („Welcher Wochentag ist Weihnachten?“) bis zu rechnerisch anspruchsvollen Fragen wie „Was ist der 100. Tag eines bestimmten Jahres?“ – übrigens der 10. April, in einem Schaltjahr der 9. April.

Nur GPT-o1 schnitt hier verlässlich ab und erreichte eine Genauigkeit von 80 Prozent. Die meisten anderen Modelle lagen deutlich darunter – besonders, wenn gerechnet werden musste. Schon die Bestimmung des richtigen Wochentags überforderte viele Systeme.

Kalenderlogik bringt viele KI-Modelle an ihre Grenzen

„Die Genauigkeit nimmt bei weniger bekannten oder rechnerisch anspruchsvollen Fragen deutlich ab“, erklären die Forscher. Zwar konnten viele Systeme bekannte Feiertage korrekt zuordnen, bei Alltagsfragen versagten sie jedoch regelmäßig – Aufgaben, die Menschen oft im Kopf oder mit einem Blick in den Kalender lösen.

Kleinere oder quelloffene Modelle schnitten besonders schlecht ab. Bei Fragen wie „Welcher Tag ist der 153. im Jahr?“ lagen ihre Antworten oft im Zufallsbereich.

Alltagstauglichkeit bleibt noch Wunschdenken

Rohit Saxena, Leiter der Studie, fasst die Erkenntnisse so zusammen: „Die meisten Menschen können schon in jungen Jahren die Uhrzeit ablesen und Kalender benutzen. Unsere Ergebnisse zeigen, dass KI bei der Ausführung dieser für Menschen grundlegenden Fähigkeiten erhebliche Defizite aufweist.“

Besonders für Anwendungen, die in Echtzeit funktionieren müssen – etwa smarte Assistenten oder automatisierte Abläufe im Beruf – stellt das ein ernsthaftes Hindernis dar.

Forscher fordern Fokus auf echte Alltagsprobleme

Die Autoren der Studie kritisieren, dass viele KI-Modelle zwar auf komplexe Denkaufgaben trainiert werden, aber bei grundlegenden Alltagsfähigkeiten versagen. „KI-Forschung konzentriert sich heute oft auf komplexe Denkaufgaben, doch ironischerweise haben viele Systeme noch immer Schwierigkeiten mit einfacheren, alltäglichen Aufgaben“, erklärt Aryo Gema von der School of Informatics in Edinburgh. „Unsere Ergebnisse legen nahe, dass es höchste Zeit ist, diese grundlegenden Lücken anzugehen.“

Denn ohne die Fähigkeit, Uhrzeiten und Kalenderdaten richtig zu erfassen, bleiben viele praktische Anwendungen wie Terminplaner, Assistenzsysteme oder smarte Haushaltsgeräte unzuverlässig – und damit im Alltag kaum nutzbar.

Kurz zusammengefasst:

- KI kann keine Uhrzeit lesen: Selbst führende Modelle wie GPT-4o erkennen die Zeigerstellungen analoger Uhren oft falsch oder raten Standardzeiten.

- Auch bei Kalenderdaten scheitern viele Systeme, vor allem bei weniger bekannten oder rechnerisch anspruchsvollen Fragen.

- Die Forscher betonen, dass grundlegende Fähigkeiten wie Zeitverständnis für den praktischen KI-Einsatz entscheidend sind – sie fehlen aber bislang deutlich.

Übrigens: KI-Modelle werden immer selbstbewusster – und täuschen dabei oft Wissen nur vor. Laut einer Studie erfinden sie lieber eine Antwort, als einzugestehen, dass sie etwas nicht wissen. Mehr dazu in unserem Artikel.

Bild: © Pexels

2 -Gedanken zu “Uhrzeit-Überraschung bei ChatGPT und Co – KI versagt bei banaler Aufgabe”