KI mit Menschenverstand: Computer denken erstmals wie wir

Die TU Berlin und Google DeepMind stellen AligNet vor: eine menschliche KI, die Bilder mit Kontext und Bedeutung wie Menschen begreift.

Auch wenn moderne KI-Modelle immer besser sehen, bleibt das tiefe visuelle Verständnis des Menschen unerreicht. © Freepik/Julos

Täglich bewerten Algorithmen Fotos, sortieren Nachrichtenbilder vor und entscheiden mit, was auf unseren Bildschirmen erscheint – auch in sozialen Netzwerken, bei Polizei-Software oder im Joballtag. Bislang erkennen diese Systeme zwar Muster in Gesichtern oder Szenen, verstehen aber kaum, worum es auf einem Bild eigentlich geht. Dieses Verständnis wollen Forscher der Technischen Universität Berlin, Experten von Google DeepMind und zwei Max-Planck-Instituten nun nachrüsten: Ihre KI soll Bilder ähnlich einordnen wie Menschen – mit Kontext, Bedeutung und klaren Beziehungen zwischen den einzelnen Bildelementen.

Die in Nature veröffentlichte Arbeit stellt damit einen neuen Ansatz vor, um künstlichen neuronalen Netzen eine Art Menschenverstand beizubringen. Die Wissenschaftler entwickelten ein System namens AligNet, das das visuelle Verständnis von Computern mit menschlicher Wahrnehmung abgleicht. Wenn Maschinen die Welt ähnlich strukturieren wie Menschen, könnten sie nicht nur erkennen, was etwas ist, sondern auch, wie es in Zusammenhang steht.

Forscher bilden menschliches Denken nach

Im Kern geht es darum, dass Menschen Wissen in Ebenen ordnen – vom Konkreten bis zum Allgemeinen. Ein Hund ist zum Beispiel ein Tier, ein Lebewesen, ein Haustier. Diese Hierarchie ist für Menschen selbstverständlich, für Maschinen jedoch schwer zu erfassen. Klassische Bildmodelle erkennen nur Formen und Farben, keine Bedeutungszusammenhänge.

Das Team der TU Berlin entwickelte deshalb ein zweistufiges Lernsystem. Ein sogenanntes „Lehrer“-Modell wurde darauf trainiert, menschliche Entscheidungen nachzuahmen – also zu beurteilen, welche Bilder ähnlich wirken und welche sich unterscheiden. Diese künstlichen Urteile dienten als Vorlage für ein zweites Modell, den „Schüler“. Dieses lernte, seine eigene Bildverarbeitung daran auszurichten und Bedeutungsebenen zu erkennen.

„Unsere zentrale Frage lautete: Was fehlt modernen Lernsystemen, damit sie sich wirklich menschenähnlich verhalten – nicht nur in der Leistung, sondern in der Organisation von Wissen?“, erklärt Dr. Lukas Muttenthaler, Erstautor der Studie.

Menschliche KI lernt schneller und sparsamer

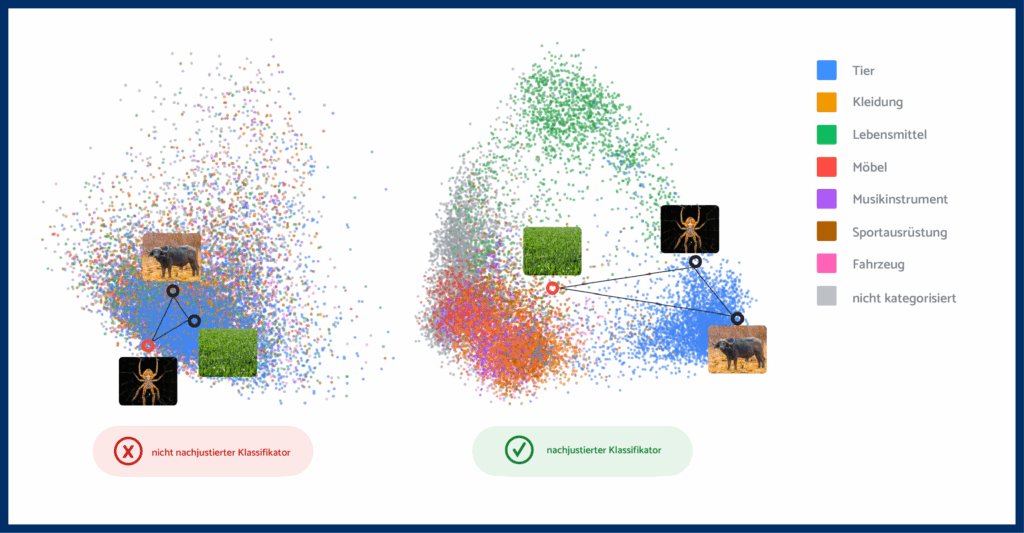

Das Besondere an AligNet ist, dass es bestehende Systeme anpasst, statt sie komplett neu zu trainieren. Dadurch reduziert sich der Rechenaufwand um ein Vielfaches. Gleichzeitig steigt die Genauigkeit. In den Tests verbesserte sich die Übereinstimmung der KI mit menschlichen Urteilen um bis zu 93 Prozent bei groben Kategorisierungen.

Die Forscher nutzten dazu eine neu entwickelte Datensammlung namens „Levels“, in der rund 500 Teilnehmer Bilder vergleichen und ihre Ähnlichkeit bewerten sollten – etwa, ob ein Vogel eher einem Fisch oder einem Hund ähnelt. So wurden nicht nur die Entscheidungen erfasst, sondern auch die Reaktionszeiten, um Rückschlüsse auf die Unsicherheit der Urteile zu ziehen.

Diese Daten flossen in das Trainingssystem ein. Die Maschinen „lernten“, dass Unsicherheit und Entscheidungszeit wichtige Hinweise auf menschliche Wahrnehmung sind. Ein Verhalten, das herkömmliche Algorithmen bisher kaum nachvollziehen konnten.

Ergebnisse zeigen deutliche Fortschritte

Nach dem Feintuning mit AligNet konnten die KI-Modelle nicht nur präziser erkennen, sie verstanden auch Zusammenhänge besser. In komplexen Lernaufgaben verbesserten sich die Ergebnisse um 25 bis 150 Prozent. Besonders auffällig war, dass die Modelle auch außerhalb ihres Trainingskontexts stabiler arbeiteten – ein häufiges Problem klassischer Systeme.

Um zu prüfen, wie „menschlich“ sich die Modelle verhalten, verglichen die Forscher anschließend, wann KI und Menschen unsicher werden. Vor der Feinabstimmung gab es praktisch keinen Zusammenhang. Nach dem Training mit AligNet lag die Übereinstimmung bei Werten zwischen 0,48 und 0,51 – vereinfacht gesagt: Immer dann, wenn Menschen länger überlegen oder zögern, zeigt auch die KI eher Unsicherheit.

„Wir schlagen eine effiziente Methode vor, um Computer-Vision-Modellen die hierarchische Struktur menschlichen Wissens beizubringen“, sagt Dr. Andrew Lampinen von Google DeepMind. „Das macht sie nicht nur verständlicher, sondern auch robuster bei schwierigen Aufgaben.“

KI wird verständlicher und verlässlicher

Das klingt theoretisch, hat aber praktische Folgen. Eine KI, die Bedeutungen versteht, kann in vielen Bereichen helfen – etwa in der Medizin, wo Bilddiagnosen vom Kontext abhängen, oder bei autonomen Fahrzeugen, die Objekte in komplexen Umgebungen sicher einordnen müssen.

Durch das neue Lernsystem werden Computerprogramme nachvollziehbarer und besser überprüfbar. Für Branchen, in denen Fehlentscheidungen teuer oder gefährlich sind, ist das entscheidend. Die Forschung könnte also langfristig die Grundlage für vertrauenswürdigere KI schaffen – Systeme, deren Entscheidungen Menschen besser nachvollziehen können.

Brücke zwischen Denken und Technik

Laut Prof. Klaus-Robert Müller von der TU Berlin verfolgt das Projekt ein übergeordnetes Ziel: „Wir verbinden kognitive Wissenschaft mit moderner Deep-Learning-Praxis und schaffen eine Brücke zwischen dem Denken von Menschen und Maschinen.“

Der Ansatz könne künftig auch in anderen Bereichen wirken, etwa bei Sprachmodellen oder Lernsystemen, die Sprache und Bild kombinieren. Eine menschliche KI, die Kategorien, Unsicherheit und Bedeutung ähnlich wie wir verarbeitet, würde nicht nur bessere Ergebnisse liefern, sondern auch transparenter handeln. So entsteht eine neue Generation lernfähiger Systeme, die weniger fehleranfällig sind und den Menschen nicht ersetzen, sondern besser unterstützen sollen.

Kurz zusammengefasst:

- Forscher der Technischen Universität Berlin, Google DeepMind und zweier Max-Planck-Institute entwickelten mit AligNet ein System, das künstliche Intelligenz lehrt, Bilder ähnlich wie Menschen zu begreifen – mit Bedeutung, Kontext und Hierarchie.

- Die „menschliche KI“ nutzt ein Lehrer-Schüler-Prinzip, um menschliche Urteile nachzuahmen, und erreicht dabei bis zu 93 Prozent genauere Ergebnisse bei groben Bildkategorien sowie 25 bis 150 Prozent Leistungssteigerung bei komplexen Aufgaben – bei deutlich geringerem Rechenaufwand.

- KI-Systeme könnten dadurch künftig nachvollziehbarer, robuster und vertrauenswürdiger werden – etwa in Medizin, autonomem Fahren oder Bildanalyse, wo das Verständnis von Zusammenhängen entscheidend ist.

Übrigens: In der Klimaforschung zeigt sich, dass einfache Physik der künstlichen Intelligenz oft überlegen ist – zumindest, wenn es um präzise Temperaturvorhersagen geht. Mehr dazu in unserem Artikel.

Bild: © Freepik/Julos

3 -Gedanken zu “KI mit Menschenverstand: Computer denken erstmals wie wir”