Hat KI einen moralischen Kompass? – So urteilen Chatbots über richtig und falsch

KI ist nicht neutral: Chatbots bewerten Alltagsdilemmata unterschiedlich und verändern dadurch unbemerkt gesellschaftliche Normen und Einstellungen.

Viele Menschen suchen Rat bei Chatbots – dadurch könnten diese Technologien langfristig auch unser Verhalten und gesellschaftliche Normen mitprägen. © Unsplash

Immer mehr Menschen vertrauen auf Chatbots, wenn sie Rat suchen oder persönliche Probleme teilen. Die Programme reagieren schnell, wirken aufmerksam und sind Tag und Nacht verfügbar. Doch ihre Antworten prägen nicht nur Gespräche, sondern auch Werte und Normen.

Forscher der UC Berkeley zeigen nun in einer Studie, nach welchen moralischen Maßstäben Chatbots urteilen. Sie prüften, wie sieben große Sprachmodelle Alltagskonflikte aus dem Reddit-Forum „Am I the Asshole?“ bewerten, einer Plattform, auf der Millionen Nutzer diskutieren, wer in einer bestimmten Situation im Recht liegt.

Forscher prüfen über 10.000 Alltagsdilemmata

Für ihre Studie spielten die Wissenschaftler mehr als 10.000 reale Fälle in die Systeme ein. Die Palette reichte von zerbrochenen Freundschaften bis zu Streit um Privatsphäre. Jedes Modell musste ein Urteil abgeben und seine Begründung liefern.

„Durch ihre Ratschläge und Rückmeldungen prägen diese Technologien, wie Menschen handeln, was sie glauben und welchen Normen sie folgen“, erklärt Studienleiter Pratik Sachdeva.

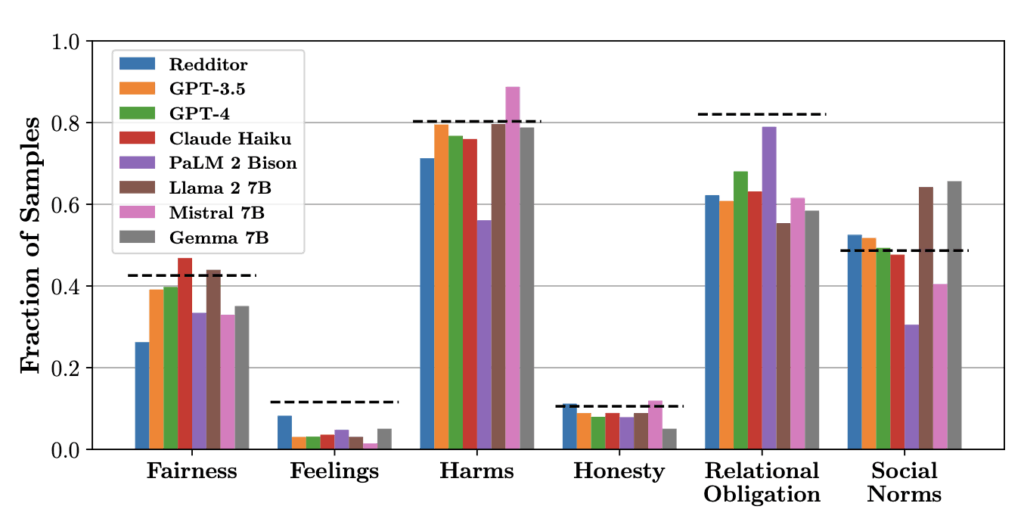

Chatbots urteilen unterschiedlich streng

Die Ergebnisse zeigten klare Unterschiede. Einige Systeme betonten Fairness und Schadenvermeidung, andere legten mehr Gewicht auf Gefühle. Ehrlichkeit spielte dagegen eine geringere Rolle. Wer gelogen hatte, kam bei manchen Modellen glimpflicher davon als jemand, der Schaden anrichtete.

Bei gleichen Fragen reagierten die Modelle zwar oft gleich, insgesamt fielen ihre Urteile jedoch sehr verschieden aus. Jeder Chatbot brachte einen eigenen moralischen Kompass mit.

Mehrheit der Chatbots stimmt oft mit Menschen überein

Ein Vergleich mit der Community ergab: In vielen Fällen deckte sich die Mehrheitsmeinung der Modelle mit der der Reddit-Nutzer. Sachdeva resümiert: „Im Prinzip kann man die Situation vergleichen, als ob man verschiedene Freunde um Rat fragt und dann Gemeinsamkeiten erkennt.“

Ein Modell fiel aus der Reihe. Mistral 7B griff besonders oft auf die Kategorie „Keine Schuldigen“ zurück, weil es den Begriff „Asshole“ wörtlicher interpretierte als andere Systeme.

Wenn Chatbots heimlich Normen formen und Verhalten verändern

Die Studie macht deutlich, dass Chatbots nicht neutral sind. Wer sie regelmäßig befragt, übernimmt womöglich unbewusst deren Wertmaßstäbe. Das kann Verhalten und Einstellungen verändern, ohne dass klar ist, welche Prinzipien dahinterstehen. Denn: Viele Chatbots sind Firmenprodukte. Niemand weiß genau, mit welchen Daten sie arbeiten – dadurch bleiben ihre Urteile schwer überprüfbar.

Wir wissen nicht, wie viele dieser Werkzeuge trainiert wurden. Wir wissen nicht, wie sie abgestimmt sind.

Pratik Sachdeva

Gerade weil Menschen Chatbots in persönlichen Fragen konsultieren, sind die Auswirkungen spürbar. Wer sie zu Beziehungsproblemen, ethischen Dilemmata oder Konflikten befragt, erhält Antworten, die von unsichtbaren Datensätzen geprägt sind. Daraus ergeben sich Risiken:

- Normenverschiebung: Wenn viele Menschen die Maßstäbe von Chatbots übernehmen, verändern sich Werte und Verhaltensweisen in der Gesellschaft.

- Fragmentierung: Unterschiedliche Modelle mit unterschiedlichen Schwerpunkten führen zu einer zersplitterten Morallandschaft.

Konsensbildung zwischen Modellen verläuft unterschiedlich

In einem weiteren Schritt untersuchten die Forscher, wie die Systeme untereinander diskutieren. Dabei zeigte sich: Modelle von OpenAI hielten stärker an ihren Bewertungen fest, andere gingen schneller auf Kompromisse ein. Damit spiegelten sich nicht nur unterschiedliche Inhalte, sondern auch abweichende Verhandlungsstile.

Die Analyse hat gezeigt: Künstliche Intelligenz entwickelt eigene Formen der Konsensbildung – mit möglichen Folgen für Politik, Justiz und Therapie.

Warum der moralische Kompass der Chatbots Transparenz braucht

Für Nutzer, Entwickler und Politik ergeben sich klare Konsequenzen:

- Nutzer sollten Chatbots nicht als letzte Instanz betrachten, sondern mehrere Perspektiven einholen und Antworten kritisch prüfen.

- Entwickler stehen in der Pflicht, ihre Modelle transparenter zu gestalten und die zugrunde liegenden Werte offenzulegen.

- Politik sollte Mindeststandards für Transparenz, Risikohinweise und Einsatzgebiete festlegen.

Die Studie verdeutlicht damit, dass Chatbots längst mehr sind als neutrale Ratgeber – ihr moralischer Kompass beeinflusst Werte und Entscheidungen bereits heute. Wie stark dieser Einfluss künftig wird, entscheidet sich daran, wie kritisch Gesellschaft und Politik damit umgehen.

Kurz zusammengefasst:

- Chatbots besitzen einen eigenen moralischen Kompass und urteilen bei Alltagskonflikten je nach Modell unterschiedlich über Fairness, Gefühle oder Ehrlichkeit.

- Eine Untersuchung der UC Berkeley mit über 10.000 Fällen aus Reddit zeigte, dass Chatbots oft konsistent, aber nicht einheitlich urteilen und dadurch Werte und Moral verschieben können.

- Für Nutzer, Entwickler und Politik entstehen Risiken und Pflichten: Kritisch prüfen, Transparenz schaffen und klare Regeln für den Einsatz festlegen.

Übrigens: KI kann nicht nur Texte schreiben, sondern auch winzige Abläufe im Körper sichtbar machen – von Viren bis zu Alzheimer-Proteinen. Ein neues Modell beschleunigt so die Suche nach wirksamen Medikamenten. Mehr dazu in unserem Artikel.

Bild: © Unsplash

1 -Gedanken zu “Hat KI einen moralischen Kompass? – So urteilen Chatbots über richtig und falsch”