Kein Strom mehr für KI auf der Erde? – Musk will Rechenzentren ins All schießen

Elon Musk denkt über KI-Rechenzentren im All nach. Grund ist Stromknappheit auf der Erde. Im Orbit wäre Solarenergie dauerhaft verfügbar.

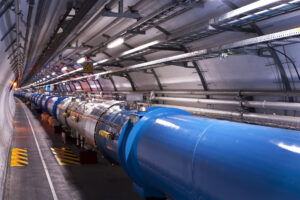

Die Falcon 9 bringt Starlink-Satelliten ins All: Was mit Starlink begann, könnte sich fortsetzen. SpaceX betreibt bereits großflächige Infrastruktur im Orbit – nun denkt Elon Musk darüber nach, dort auch KI-Rechenzentren anzusiedeln. © Wikimedia

Auf der Erde gibt es nicht genug Strom für die gigantischen KI-Rechenzentren. Im All dagegen scheint immer die Sonne und es gibt jede Menge Platz. Deshalb denkt Elon Musk darüber nach, Rechenleistung künftig nicht mehr am Boden, sondern im Orbit zu betreiben. Dafür hat sein Raumfahrtunternehmen SpaceX die KI-Firma xAI übernommen und beide Geschäfte unter einem Dach gebündelt. Für Musk ist das vor allem eine Kostenfrage. Stromnetze, langwierige Genehmigungen und Hitze bremsen den Ausbau auf der Erde. Im All dagegen stünde Energie dauerhaft zur Verfügung.

In einem langen Gespräch im Podcast Cheeky Pint erklärt Musk, wo er das eigentliche Problem der KI-Entwicklung sieht. Nicht bei Software oder Chips, sondern bei der Energieversorgung.

Zu wenig Strom auf der Erde – darum denkt Musk an KI-Rechenzentren im All

Der Engpass beginnt am Boden. In vielen Industrieländern wächst die Stromproduktion kaum noch. Genehmigungen dauern Jahre. Netze sind ausgelastet. Neue Kraftwerke entstehen langsam. Gleichzeitig steigt der Bedarf von Rechenzentren rapide. Hochleistungs-GPUs benötigen enorme Energiemengen – und sie bleiben nicht allein.

Musk rechnet vor, dass der reale Strombedarf weit über der reinen Chip-Leistung liegt. Kühlung, Netzwerktechnik, Speicher und Sicherheitsreserven treiben den Verbrauch stark nach oben. In heißen Regionen kann allein die Kühlung den Energiebedarf um rund 40 Prozent erhöhen. Weitere Reserven kommen hinzu, um Wartung und Ausfälle abzufangen.

Wenn KI-Rechenzentren die Dimension eines Kraftwerks erreichen

Ein Beispiel aus einem Rechenzentrum auf der Erde macht die Dimension greifbar: Rund 110.000 leistungsstarke KI-GPUs benötigen zusammen mit Kühlung, Netzwerktechnik und Reserven etwa 300 Megawatt Strom. Das entspricht der Leistung eines großen Kraftwerks – für einen einzigen Standort. Wachsen solche Anlagen weiter, steigt der Bedarf schnell in den Gigawatt-Bereich. Schon wenige dieser Rechenzentren würden so viel Strom verbrauchen wie ganze Großstädte.

Musk schildert im Gespräch die Schwierigkeiten aus eigener Erfahrung. Beim Aufbau eines neuen KI-Rechenzentrums habe sein Team private Kraftwerke errichten müssen, weil Netzanbindungen zu langsam kamen. Genehmigungen, Lieferengpässe bei Turbinen und fehlende Netzkapazitäten verzögerten den Ausbau erheblich.

Solarstrom im All arbeitet ohne Nacht, Wetter und Speicher

Im Weltraum entfallen viele dieser Probleme. Solaranlagen arbeiten dort ohne Atmosphäre, ohne Wolken und ohne Tag-Nacht-Wechsel. Die Ausbeute liegt deutlich höher als auf der Erde. Musk spricht von etwa dem Fünffachen. Zudem fallen Batteriespeicher weg, die auf der Erde nötig sind, um Nächte und Flauten zu überbrücken.

„Es ist tatsächlich viel günstiger, Solarenergie im All zu erzeugen“, sagt Musk. Seine Prognose ist klar formuliert: „In 36 Monaten, wahrscheinlich eher in 30, wird der wirtschaftlich sinnvollste Ort für KI das All sein.“ Die Aussage bezieht sich nicht auf Technikspielereien, sondern auf Kosten pro Recheneinheit.

Kühlung im All bleibt ein physikalisches Nadelöhr

Allerdings löst die Verlagerung ins All nicht jedes technische Problem. Zu Fragen der Kühlung im All äußerte sich Musk in dem Gespräch nicht. Ein zentrales technisches Thema ist dabei die Abwärme. Im Weltraum fehlt eine Atmosphäre, die Wärme aufnehmen könnte. Sie lässt sich dort nicht wie auf der Erde über Luftströmung oder Wasser abführen, sondern nur durch Wärmestrahlung ins All. Dafür sind große Radiatorflächen nötig, die Hitze im Infrarotbereich abstrahlen. Mit wachsender Rechenleistung müssen diese Flächen entsprechend größer werden.

Technische Abschätzungen zeigen die Dimension: Um bereits ein Megawatt Abwärme abzuführen, wären Radiatoren von rund 1.000 bis 1.200 Quadratmetern erforderlich. Bei Rechenzentren im Multi-Megawatt- oder gar Gigawatt-Bereich würde die benötigte Fläche schnell auf mehrere Tausend Quadratmeter anwachsen. Das erhöht nicht nur die Masse der Anlagen, sondern auch Startkosten, Konstruktionsaufwand und die Anfälligkeit der Systeme.

Dass Kühlung im All grundsätzlich möglich ist, zeigen bestehende Raumfahrtsysteme wie die Internationale Raumstation. Dort wird Abwärme über große Radiatoren abgeführt, allerdings in deutlich kleineren Leistungsordnungen von einigen zehn Kilowatt. Für KI-Rechenzentren mit um ein Vielfaches höherer Leistungsdichte existieren bislang keine erprobten Lösungen im Dauerbetrieb.

Wartung im Orbit gilt laut Musk als lösbar

Ein häufiger Einwand betrifft die Wartung. GPUs fallen aus. Trainingsprozesse sind empfindlich. Wie lässt sich das im All handhaben? Musk verweist auf Erfahrungen mit moderner Hardware. Nach einer kurzen Einlaufphase seien die Ausfallraten gering. „Sobald die Anfangsprobleme geklärt sind, laufen die Chips sehr zuverlässig“, sagt er.

Die eigentliche Grenze sieht Musk woanders: in der Skalierung. Auf der Erde stoße der Ausbau bei Terawatt-Leistungen an politische, geografische und industrielle Grenzen. Im All lasse sich die Leistung schrittweise erweitern, solange Trägerraketen verfügbar seien und Solarpaneele produziert würden.

Tausende Raketenstarts für neue KI-Leistungsdimensionen

Für große Leistungen braucht es viele Starts. Musk spricht offen über Größenordnungen, die heute kaum vorstellbar wirken. Hunderte Gigawatt pro Jahr seien möglich. Langfristig sogar ein Terawatt jährlich, bevor Treibstoff und Logistik neue Engpässe setzen. Das würde Tausende Starts bedeuten.

Die Rechnung folgt einem einfachen Prinzip: Leistung, Masse und Startkosten müssen zusammenpassen. Solarpaneele im All sind leichter als auf der Erde, weil sie kein schweres Glas und keine massiven Rahmen benötigen. Auch das senkt Kosten. Der Strom pro Kilogramm Nutzlast steigt deutlich.

Energie ersetzt Chips als Engpass der KI

Die Argumentation mündet in eine klare Verschiebung der Perspektive. Nicht Algorithmen, nicht Trainingsdaten, nicht Chips begrenzen das Wachstum. Es ist die Energie. Musk bringt es zugespitzt auf den Punkt: „Die Chips werden bald schneller produziert, als wir sie einschalten können.“

Diese Sichtweise erklärt, warum Rechenzentren zunehmend als Teil der Energieinfrastruktur verstanden werden. Wer KI skalieren will, muss Strom im industriellen Maßstab sichern. Der Weltraum erscheint in dieser Logik nicht als Flucht, sondern als Ausweichroute.

Zieht China kampflos davon?

In dem Gespräch geht Musk auch auf die geopolitische Dimension der Pläne ein. Er verweist darauf, dass China bei Raumfahrt, Energie und industrieller Infrastruktur systematisch vorgeht und langfristig investiert. Während westliche Staaten durch Regulierung, Genehmigungen und politische Abstimmung gebremst würden, entstehe so ein struktureller Vorsprung. Gemeint sind Trägerraketen, Satellitenproduktion und Konzepte zur Energiegewinnung im All.

Wer diese Infrastruktur früh skaliert, sichere sich Einfluss auf Energieversorgung, Datenverarbeitung und industrielle Wertschöpfung, mahnt Musk. Entscheidend sei weniger die einzelne Technologie als das Tempo, mit dem Staaten solche Systeme aufbauen und miteinander verknüpfen.

Offene Fragen zu Finanzierung und Regulierung bei SpaceX und xAI

Beobachter sehen die Zusammenlegung von SpaceX und xAI allerdings mit einiger Zurückhaltung. Sie verweisen darauf, dass xAI Berichten zufolge monatlich rund eine Milliarde Dollar verbrennt und bislang kein tragfähiges Geschäftsmodell erkennbar ist. Ein möglicher Börsengang von SpaceX könnte zwar zusätzliches Kapital erschließen, würde jedoch auch Risiken bündeln.

Carsten Mumm und Andreas Walter weisen laut Tagesschau darauf hin, dass das fusionierte Unternehmen stark regulierte Bereiche vereint und sicherheitsrelevante Interessen berührt – Aspekte, die sich dämpfend auf Bewertung und Umsetzung auswirken könnten.

Kurz zusammengefasst:

- Der Engpass der KI heißt Strom: Nicht Rechenchips, sondern Energie, Netze und Genehmigungen bremsen den Ausbau großer KI-Rechenzentren auf der Erde.

- Musks Ansatz: Rechenleistung soll ins All verlagert werden, wo Solarenergie dauerhaft verfügbar ist und Flächenknappheit entfällt – aus seiner Sicht vor allem eine Kostenfrage.

- Offene technische Fragen: Die Kühlung im All gilt als ungelöstes Thema, da Abwärme nur über große Radiatorflächen abgeführt werden kann; auch weitere technische und logistische Herausforderungen sind noch offen.

Übrigens: Während Elon Musk darüber spricht, Energie und Rechenleistung ins All zu verlagern, warnen Forscher vor neuen Risiken im dicht belegten Orbit: Solarstrom aus dem All soll per Laser übertragen werden – schon kleine Abweichungen könnten Satelliten beschädigen. Welche Gefahren das für Kommunikation, Navigation und den wachsenden Weltraumverkehr bedeutet, mehr dazu in unserem Artikel.

Bild: © U.S. Space Force photo by Joshua Conti via Wikimedia unter public domain