Mensch schlägt Maschine: Wir lernen aus wenigen Beispielen, KI braucht Millionen Daten

Menschen lernen flexibel aus wenigen Beispielen, Maschinen brauchen riesige Datenmengen und scheitern oft bei unbekannten Situationen.

Nur durch ein vertieftes Verständnis der Unterschiede und Gemeinsamkeiten können KI-Systeme künftig so gestaltet werden, dass sie menschliche Werte und Entscheidungslogiken besser nachvollziehen und unterstützen. (Symbolbild) © Pexels

An jeder Ecke begegnet uns heute Künstliche Intelligenz – in Navigationssystemen, in Sprachassistenten oder bei medizinischen Anwendungen. Doch hinter der scheinbar mühelosen Technik steckt ein Grundproblem: Maschinen lernen auf ganz andere Weise als Menschen. Während wir aus wenigen Eindrücken neue Regeln ableiten können, brauchen Computer Millionen Datenpunkte.

Warum diese Unterschiede entscheidend für unsere Zukunft mit KI sind, hat eine interdisziplinäre Zusammenarbeit von mehr als 20 Experten aus international führenden Forschungseinrichtungen, unter anderem der Universität Bielefeld, Bamberg, Amsterdam und London, in einem Fachartikel dargelegt.

Die Forscher kommen zu dem Schluss: Mensch und Maschine lernen nicht nur unterschiedlich, sie ziehen auch völlig andere Schlüsse aus denselben Informationen.

Generalisierung unterscheidet menschliches Denken von KI-Methoden

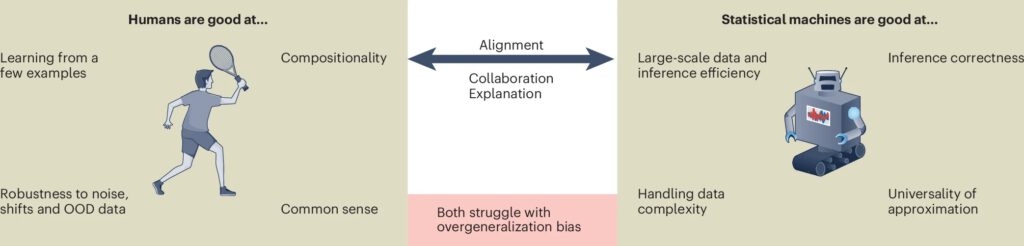

Generalisierung bedeutet, Wissen von bekannten Situationen auf neue Probleme zu übertragen. Sie entscheidet darüber, wie flexibel Menschen oder Maschinen auf Veränderungen reagieren. Während Menschen dabei stark auf Erfahrung und Kausalität bauen, stützen sich KI-Systeme auf Datenmuster und statistische Berechnungen.

„Die größte Herausforderung ist, dass ‚Generalisierung‘ für Mensch und KI-Systeme völlig unterschiedliche Dinge bedeutet“, erklärt Benjamin Paaßen von der Universität Bielefeld.

Die Studie vergleicht drei Formen von Generalisierung:

- Prozess: Wie entstehen Regeln oder Konzepte aus Beispielen?

- Produkt: Welche Kategorien oder Modelle entstehen daraus?

- Operator: Wie lassen sich diese Modelle auf neue Daten anwenden?

Menschen sind flexibel, Maschinen streng an Daten gebunden

Menschen können schon aus wenigen Beispielen verlässliche Schlüsse ziehen. Sie begründen ihre Entscheidungen und stützen sich dabei auf Wissen und Ursache-Wirkungs-Zusammenhänge.

Maschinen dagegen können riesige Datenmengen effizient auswerten, doch sie bleiben auf den gelernten Bereich beschränkt. Die Forscher nennen in diesem Zusammenhang das sogenannte „No-free-lunch-Theorem“: „Die Generalisierbarkeit statistischer Maschinen ist im Durchschnitt über alle Verteilungen hinweg konstant.“ Mit anderen Worten: Ohne Vorwissen bleibt die Maschine auf ihr Trainingsmaterial angewiesen.

KI-Systeme liefern Chancen – und riskante Fehler

Große Sprachmodelle beeindrucken mit Texten zu fast jedem Thema. Sie nutzen „few-shot learning“, können also aus wenigen Beispielen viel ableiten. Doch die Grenzen sind deutlich: Modelle neigen zu falschen Aussagen. Im Fachjargon spricht man von Halluzinationen.

Ein Beispiel: Ein KI-System beschreibt einen Tumor falsch, weil die Trainingsdaten unvollständig waren. Für Laien klingt die Antwort überzeugend, für Experten ist sie schlicht fehlerhaft. Genau hier liegt das Risiko.

Transparenz entscheidet über Vertrauen

Während Menschen ihre Überlegungen erklären, bleibt maschinelles Denken oft unsichtbar. Die Systeme gelten als Black Box. Das macht Entscheidungen schwer nachvollziehbar.

Barbara Hammer von der Universität Bielefeld sagt: „Wenn wir KI-Systeme in den Alltag integrieren wollen, sei es in der Medizin, im Verkehr oder bei der Entscheidungsfindung, müssen wir verstehen, wie diese Systeme mit dem Unbekannten umgehen.“

Standards sollen Sicherheit bringen

Die Wissenschaftler fordern klare Rahmenbedingungen. Denn der Begriff „Generalisierung“ wird in der KI-Forschung ganz unterschiedlich verwendet. Einheitliche Definitionen und Tests wären nötig, um Maschinen verlässlich bewerten zu können.

Das betrifft konkrete Bereiche:

- Medizin: Nur Systeme mit nachvollziehbaren Entscheidungen sind akzeptabel.

- Verkehr: Autonomes Fahren braucht klare Regeln, wie mit neuen Situationen umzugehen ist.

- Verwaltung: KI muss Entscheidungen so erklären, dass sie rechtlich überprüfbar sind.

Mensch liefert Kontext, Maschine bringt Rechenkraft

Stärke entsteht dort, wo sich die Fähigkeiten ergänzen: Maschinen überzeugen mit Effizienz und Rechenleistung, Menschen mit Kontextwissen und dem Verständnis von Zusammenhängen. Das Ziel lautet den Forschern zufolge: „KI-Systeme so handeln lassen, dass sie unseren Präferenzen entsprechen.“

Damit rückt eine Zukunft näher, in der KI den Arzt bei der Diagnose unterstützt oder Verwaltungsprozesse schneller macht – ohne die menschliche Kontrolle zu ersetzen.

Kurz zusammengefasst:

- Menschen lernen flexibel, können aus wenigen Beispielen verallgemeinern und ihre Entscheidungen begründen, während Maschinen an große Datenmengen gebunden sind.

- KI-Systeme liefern präzise Ergebnisse innerhalb bekannter Daten, machen aber Fehler bei neuen Situationen und neigen zu „Halluzinationen“.

- Für den Einsatz in Medizin, Verkehr und Verwaltung fordern Fachleute klare Standards und eine enge Zusammenarbeit zwischen Mensch und Maschine.

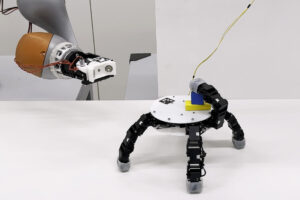

Übrigens: In München haben Maurerlehrlinge zusammen mit einem Roboter eine Ziegelwand gebaut, die sich an Sonne und Schatten anpasst und so das Raumklima reguliert. Digitale Planung, präzise Robotik und Handwerk greifen ineinander. Mehr dazu in unserem Artikel.

Bild: © Pexels