ALS-Patient spricht wieder – Neue Sprachhilfe verwandelt Gedanken in flüssige Gespräche

Eine neue Technik bringt verlorene Stimmen zurück. Hirnsignale werden erstmals so verarbeitet, dass ALS-Betroffene wieder flüssig sprechen können.

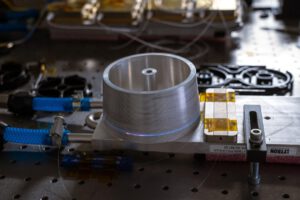

Das neue System ermöglichte es dem an ALS erkrankten Studienteilnehmer, über einen Computer in Echtzeit mit seiner Familie zu „sprechen“, seine Betonung zu ändern und einfache Melodien zu „singen“. © UC Regents

Für viele Patienten mit Amyotropher Lateralsklerose (ALS) bedeutet der Verlust der Stimme einen schweren Einschnitt ins Leben. Die Krankheit raubt Betroffenen die Kontrolle über ihre Muskeln, auch die, die für das Sprechen gebraucht werden. Was bleibt, ist das klare Denken, aber die Worte kommen nicht mehr heraus. Forscher der University of California in Davis haben nun eine Sprachhilfe entwickelt, die ALS-Patienten sofort wieder eine Stimme gibt – in Echtzeit.

Sprachhilfe bei ALS erlaubt erstmals flüssige Gespräche in Echtzeit

Bisher konnten Betroffene oft nur noch mit Hilfe von Computern kommunizieren, die Texte in Sprache umwandelten. Doch diese Systeme sind langsam, unnatürlich und lassen keine echte Unterhaltung zu. „Die Übersetzung neuronaler Aktivität in Text, wie es unser vorheriges Sprach-BCI (brain-computer interface / Gehirn-Computer-Schnittstelle) tat, ist vergleichbar mit Textnachrichten. Im Vergleich dazu ist diese neue Echtzeit-Sprachsynthese eher wie ein Telefonanruf, “ erklärt Forschungsleiter Sergey Stavisky.

Das neue System erfasst die Hirnsignale direkt im Sprachzentrum. Dort werden die Signale sofort in hörbare Sprache umgewandelt. Die Verzögerung liegt bei nur 10 Millisekunden – das ist schneller als ein Wimpernschlag. Dadurch können Patienten wieder flüssig sprechen, Pausen einlegen, auf Gesprächspartner reagieren und sogar Emotionen in ihre Stimme legen.

Wie die Technik funktioniert

In einer aufwendigen Operation implantierten Ärzte dem Patienten vier kleine Elektroden-Arrays ins Gehirn. Die insgesamt 256 Elektroden sitzen im präzentralen Gyrus, einer Hirnregion, die für die Steuerung der Sprache verantwortlich ist. Der 45-jährige Mann, der an der Studie teilnimmt, bekam das System fünf Jahre nach Beginn seiner ALS-Symptome eingesetzt.

Die Elektroden messen die elektrische Aktivität der Nervenzellen, während der Patient innerlich spricht, also die Wörter nur denkt, aber nicht mehr laut aussprechen kann. Diese Signale werden dann von speziellen Algorithmen ausgewertet. So entsteht ein direkter Weg von den Gedanken zur Sprache.

Künstliche Intelligenz lernt mit

Die Forscher trainierten die Systeme, indem der Patient Sätze still aussprach. Die Algorithmen ordneten die gemessenen Signale den beabsichtigten Lauten zu. Projektwissenschaftlerin Maitreyee Wairagkar beschreibt das so: „Unsere Algorithmen ordnen neuronale Aktivität den intendierten Lauten in jedem Moment zu. Das ermöglicht es, Nuancen in der Sprache zu synthetisieren und dem Teilnehmer die Kontrolle über das Tempo seiner BCI-Stimme zu geben.“

Die künstlich erzeugte Sprache war für Zuhörer deutlich besser zu verstehen als bei bisherigen Systemen. Rund 60 Prozent der Wörter wurden korrekt verstanden. Zum Vergleich: Ohne das System lag die Verständlichkeit bei nur vier Prozent. Damit wird die alltägliche Kommunikation für Patienten enorm erleichtert.

Auch Melodien sind wieder möglich

Der Mann konnte nicht nur Wörter sprechen, sondern auch Fragen stellen, Betonungen setzen und einfache Melodien singen. Das ermöglicht eine viel lebendigere Ausdrucksweise, die der natürlichen Stimme sehr nahekommt. Emotionen, Nachdruck oder Fragen lassen sich so direkt übermitteln.

Stavisky erklärt, wie sehr diese Echtzeitfunktion die Gespräche verändert: „Mit sofortiger Sprachsynthese können Nutzer des Neuroprothesen-Systems besser in Gespräche eingebunden werden. Sie können zum Beispiel unterbrechen, und andere Menschen werden sie weniger wahrscheinlich versehentlich unterbrechen.“ Gerade dieser Aspekt der Spontanität fehlte bei bisherigen Systemen vollständig.

Die Stimme als Teil der Persönlichkeit

„Unsere Stimme ist ein Teil dessen, was uns ausmacht. Die Fähigkeit zu verlieren, zu sprechen, ist für Menschen mit neurologischen Erkrankungen verheerend. Die Ergebnisse dieser Forschung geben Hoffnung für Menschen, die sprechen wollen, es aber nicht können,“ sagt der am Projekt beteiligte Neurochirurg David Brandman.

Die neue Gehirn-Computer-Schnittstelle wurde bisher nur bei einem Patienten getestet. Doch die Forscher arbeiten bereits an weiteren Studien mit Menschen, die ihre Sprache durch Schlaganfälle oder andere neurologische Erkrankungen verloren haben. Ziel ist es, die Technik für viele Betroffene nutzbar zu machen.

Kurz zusammengefasst:

- Die neue Sprachhilfe der University of California in Davis ermöglicht ALS-Patienten, Hirnsignale in Echtzeit in gesprochene Sprache umzuwandeln.

- Implantierte Mikroelektroden erfassen die Hirnaktivität direkt im Sprachzentrum und ermöglichen so eine natürliche Sprachwiedergabe mit Betonung, Intonation und sogar Gesang.

- Die Verständlichkeit der erzeugten Sprache stieg von nur 4 auf fast 60 Prozent; Patienten können damit wieder flüssig kommunizieren und aktiv an Gesprächen teilnehmen.

Übrigens: Computerstimmen wirken sympathischer, wenn sie mit einer vertrauten Stimme sprechen. Das könnte nicht nur ALS-Betroffenen in Zukunft noch mehr helfen. Mehr dazu in unserem Artikel.

Bild: © UC Regents